BTC/HKD+0.9%

BTC/HKD+0.9% ETH/HKD+4.51%

ETH/HKD+4.51% LTC/HKD+3.42%

LTC/HKD+3.42% ADA/HKD+3.19%

ADA/HKD+3.19% SOL/HKD+3.71%

SOL/HKD+3.71% XRP/HKD+1.83%

XRP/HKD+1.83%來源:“峰瑞資本”(ID:freesvc),作者:陳石

“ChatGPT”可能是從2022年底至今,最為出圈的科技熱詞之一。GPT是Generative Pre-trained Transformer的縮寫,表示生成型預訓練變換模型。這個由OpenAI研發的語言模型激起了人們對AI技術新一輪的熱情。人們與ChatGPT暢談古今,請它翻譯文本、編代碼、寫文章。(p.s.猜猜看,這篇文章是不是ChatGPT寫的?)

爆火背后,我們試圖對ChatGPT有更多理解。如果說以ChatGPT為代表的AIGC(AI-generated content,AI生產內容)本質上是技術革命,那么,脫離了對技術的認知來討論這個議題,難免會出現偏差。

在這篇報告,我們會先梳理ChatGPT發展的歷史沿革:它從哪里來,到底是什么技術在驅動它向前。我們的思考也會圍繞人們對它的討論而展開:它能火多久,有機會成為“人類大腦”或通用人工智能(AGI)嗎?同樣重要地,我們會把落點放在創投行業,來探討與AIGC相關的創業及投資機會。

▍ChatGPT的本源——語言模型

ChatGPT其實是一種語言模型。依據OpenAI官方的介紹,ChatGPT已具備理解和生成人類語言文本的能力,可以跟人類輕松對話。

圖片來源:OpenAI官網

人類的語言非常復雜,而比語言更復雜的,是創造語言的思維。人們曾經試圖給語言建模,但是一直沒有取得顯著性的成功。而ChatGPT則為語言建模打開了新的窗口,這也是它的誕生轟動全球的原因之一。

Wikipedia對語言模型的定義是:“單詞序列的概率分布,給定任何長度為m的單詞序列,語言模型通過對語言的文本語料庫進行訓練,來生成概率分布”。斯坦福的公開課說得更為直接:“語言模型就是用來預測下一個出現的詞的概率”。(斯坦福的定義概括了GPT的核心原理,而不是BERT類語言模型的原理。或許這能從側面反映,人們已將GPT采用的技術路線,視為主流語言模型路線。)

GPT系列的語言模型,其主要目標是預測下一個單詞。比如,前半句是“the students opened their”,語言模型要預測的是下一個單詞出現“books”或者“laptops”或者“exams”等詞匯的概率分別是多少。語言模型的技術原理雖然簡單,但是卻衍生出了ChatGPT這樣智能、有復雜應用場景的產品。

▍ChatGPT可能是當前最成功的大型語言模型,我們正在經歷iPhone Moment

ChatGPT可能是目前最成功的語言模型,人們把當下這個ChatGPT誕生的時刻稱為“iPhone moment”。

GPT是Generative Pre-trained Transformer 的縮寫。Transformer神經網絡算法是當前最新的一種算法模型,我們會在下文展開。GPT系列模型都是語言模型,是新型神經網絡算法、新型模型訓練方式加上海量數據算力多重因素疊加產出的成果。

GPT模型有幾個主干版本,從 GPT-1、GPT-2、GPT-3演進到最新的GPT-3.5版本。

當下人們使用的ChatGPT是在3.5版本的基礎上,專門針對人類需求做了大量微調,引導模型輸出更符合人類需求的結果。這讓GPT模型逐漸“社會化”,變得更像人。經過微調的ChatGPT“情商”變高了,不再只是個話癆,也不再那么口無遮攔。

▍ChatGPT的誕生過程

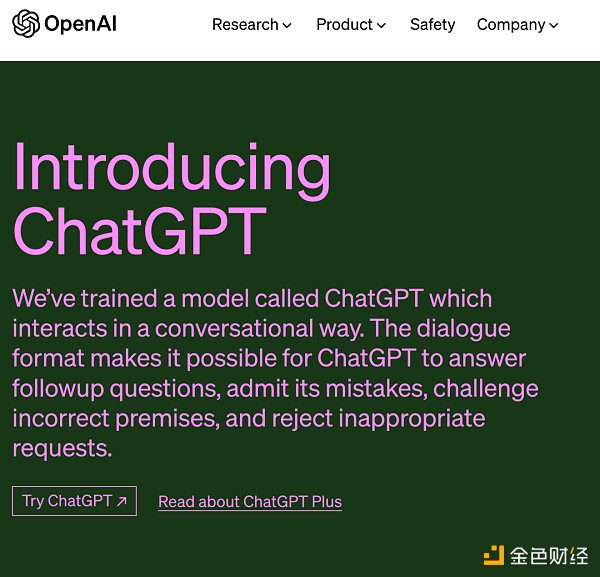

圖片來源:微信公眾號@AI語者

在ChatGPT問世之前,GPT模型經歷了怎樣的發展歷程?

2017年6月,Google發布Transformer這一神經網絡算法模型,它為大型語言模型的發展奠定了基礎。

可編程信譽協議Spectral完成675萬美元融資,Polychain Capital領投:11月13日消息,基于以太坊的可編程信譽協議Spectral宣布完成675萬美元融資,Polychain Capital領投,Mike Novogratz旗下Galaxy Digital、Chamath Palihapitiya旗下Social Capital、ParaFi Capital、Edge & Node Ventures(The Graph)、MetaPurse Ventures參投。Spectral開發用于評估Web3中信用風險的基礎設施,并為可編程信譽的新資產類別奠定了框架。(Globenewswire)[2021/11/13 6:50:25]

一年之后,OpenAI公司推出了GPT-1,GPT-1采用語言模型預訓練+微調訓練兩階段的訓練方法,在問答和常識推理、語義相似度、分類等任務中,取得了還不錯的語言任務執行效果。

2018年10月,Google推出另一個語言模型——BERT,效果超過GPT-1。

圖片來源:知乎@雅正沖蛋

GPT和BERT都是基于Transformer衍生出的算法,但在技術路線上各有側重。GPT基于 Transformer 右邊部分,叫解碼器。BERT基于 Transformer 的左邊部分,叫編碼器。

GPT的技術原理是預測下一個詞,你可以看作是“文字接龍”,你寫出前面的句子,由GPT來猜下一個詞。但BERT更像是“完形填空”,其技術原理是把一句話中某個詞給遮擋住,然后請BERT來猜。

解碼器擅長創作,編碼器擅長理解,當時它們要做的更多是屏蔽語言模型(Masked LM,類似“完形填空”)、相鄰句子判斷(Next Sentence Prediction,判斷句子是否能相連)這類偏閱讀理解的任務,因此BERT占了上風。

2019年,GPT-2發布,它采用15億個參數的Transformer解碼器,在當時是個比較大的模型。相比BERT,OpenAI研究人員發現,GPT-2預訓練的語言模型無需微調訓練,可直接執行多種下游任務。這個發現堅定了研究人員沿著現有技術路線,繼續研發的決心。

2020年5月,GPT-3誕生,它采用了史無前例的1750億參數的Transformer解碼器,用了接近5000億單詞的文本訓練數據。整個訓練過程可以說是“大力出奇跡”,讓GPT-3在文字生成方面實現質的飛躍。GPT-3除了可以出色完成文字生成、翻譯、問答和文本填空等語言類任務外,還“涌現”出了其他一些智能,包括上下文學習,以及更強大的零樣本和少樣本執行任務的能力,等等。

GPT-3生成的文本質量非常高,有時候人們甚至難以區分文本到底是人類寫的,還是GPT-3生成的。

基于GPT-3,已經衍生出很多應用,人們用GPT-3來創作各種類型的文本。有人用它寫了一篇新聞,被某熱門新聞點評網站排到頭部。一家名為Jasper的公司利用GPT-3為企業提供商業文本寫作服務,2022年其收入達到9000萬美元左右。

GPT-3之后,OpenAI通過增加程序代碼訓練和人類反饋強化學習等多種訓練手段,并將主版本升級到GPT-3.5。最終,2022年11月,ChatGPT橫空出世。

▍訓練GPT-3模型的三“大”要素:算法、數據、算力

我們稱GPT-3為大模型,這個“大”體現在哪些地方?

首先是算法。GPT-3采用的是Transformer的解碼器,具有1750億個參數和2048個Token(可簡單理解為單詞,下同)的訓練文本長度。

圖片來源:OpenAI團隊論文 《Language Models are Few-Shot Learners》

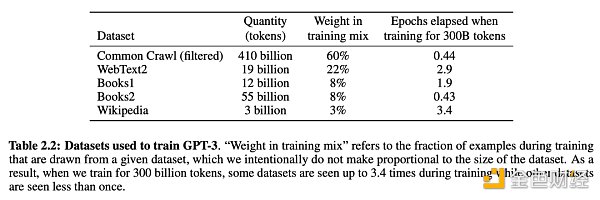

第二是數據。上圖是GPT-3的訓練數據,總共接近5000億個token的文本,主要包括Common Crawl、Webtext2、Books1、Book2、Wikipedia等等。其中占比最大的訓練數據是Common Crawl,它是一個開源的數據集,抓取并保存了全球大量網頁的數據。

被黑客攻擊的Cryptopia Exchange進入索賠處理的第二階段:10月7日消息,Cryptopia是一家總部位于新西蘭的加密貨幣交易所,在2019年5月遭受了數百萬美元的大規模黑客攻擊,它向用戶宣布清算過程的“第二階段”已經開始。此階段將重點關注受影響用戶的身份驗證。截至2021年6月,已有超過55,000名用戶完成了索賠登記步驟。幾個月前,一名前雇員承認在清算過程中竊取了價值250,000美元的資金。(BeinCrypto)[2021/10/7 20:11:22]

第三是算力。據微軟發布的信息, OpenAI 使用一臺全球排名前5的超級計算機系統來訓練GPT-3,該系統擁有超過28.5萬個CPU核心,1萬個GPU和每秒400G的網絡。據悉其訓練成本約為1200萬美元。

ChatGPT誕生以來,引發的討論非常多。那么說回來,人們如何看待這個新事物,對它又有什么期待?雖然眾說紛紜,有3個議題是被頻繁提到的。

▍人們肯定ChatGPT是一個稱職的語言模型

首先,ChatGPT是迄今為止最成功的人類語言模型,已經具備形式語言能力(洞悉語言的規則模式等知識)。

ChatGPT具備理解和生成人類語言文本的能力,可跟人類輕松對話。它用數據驅動的大型神經網絡的計算方式,某種程度上解碼了人類語言的內部規律。這個內部規律不是某種公式,而是一個神秘、暫不被人類理解的權重參數矩陣。

以前,人們認為算法模型如果僅靠輸入文本,很難獲取關于語言的知識。但如今,ChatGPT可以從文本中直接學習語言的層次結構和抽象類別等,這是一種無監督學習的能力。

此外,ChatGPT也不只是個話癆。它可以寫作文、創作詩歌、撰寫商業文本、翻譯、做閱讀理解、代碼理解和生成等。可以說,作為一個語言模型,ChatGPT已經比較稱職。

▍人們期待ChatGPT具有思維能力

人們對ChatGPT的期望不僅僅是語言模型,人們甚至期待ChatGPT成為一個思維機器,發展出功能語言能力(用語言思考和做事的能力)。

ChatGPT“涌現”出一些智能,包括上下文學習(理解和學習人類對話輸入文字的能力)、世界知識抽象(例如事實性知識和常識)、執行泛化任務(包括沒有做過的新任務)、復雜推理等。然而,當前ChatGPT的這些功能都還不算強大,出錯甚至崩潰時有發生。

當前,人們在思維機器方向的探索有很多,例如有一種借助思維鏈(Chain of Thought)的方法,試圖引導或者優化語言模型展現出復雜的推理能力。這些研究方向的進展仍在持續。

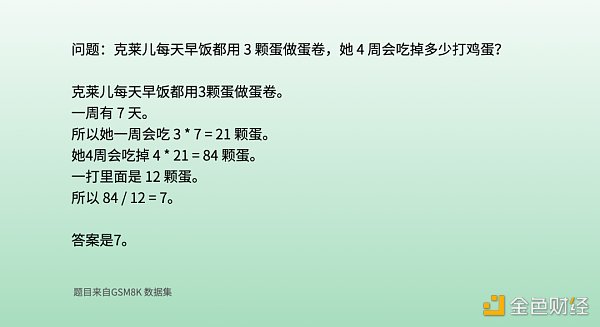

上圖展示的是,一位科研人員在跟ChatGPT的對話中,通過分步驟提示引導的示例訓練(引導過程未展示),使ChatGPT展現出分步驟思考和計算的能力。據分析,ChatGPT的這個能力來自GPT-3.5模型本身,思維鏈訓練方法只是讓它意識到應該用這種方式來思考和回答問題。整個過程有點類似老師輔導學生做題。

雖然這道題對于10歲的孩子來說很容易,但對語言模型來說卻很難,主要是由于數學和語言混合在一起。這類問題只是開始,當前思維鏈的前沿科研工作已經轉向更有難度的問題,例如高中、大學,甚至是國際數學奧林匹克問題。

加利福尼亞大學洛杉磯分校(UCLA)近期的一篇論文發現,ChatGPT似乎展現出了類比推理的能力。

什么叫類比推理?推理分三種,包含演繹、歸納、類比。“類比推理通常被視為人類抽象和概括能力的典型能力。在廣泛的問題類型中,ChatGPT達到或者超越人類水平...顯示出這種零樣本類比推理的能力。”

然而,ChatGPT的推理能力因其對世界缺乏物理理解而受限,因為它僅僅依靠文本輸入,缺少視覺(圖像和視頻)、聲音、嗅覺等多模態數據輸入。文本對世界的物理描述是有限的,比如你很難通過文字描述清楚一間屋子里不同物品的位置具體,相反,看一張關于這間屋子的圖片,物品的位置信息就一目了然。

聽說GPT-4將于2023年發布,屆時會加入視覺等多模態數據輸入,這將有望進一步提升它的智能。

DEX聚合器1inch.exchange集成JulSwap:3月3日消息,官DEX聚合器1inch.exchange官方宣布集成JulSwap作為流動性提供者。[2021/3/3 18:09:39]

▍對于ChatGPT能否成為“人類大腦”或通用人工智能,人們持有巨大爭議

目前,針對ChatGPT是否能夠變成“人類大腦”或者通用人工智能(AGI),爭議還非常大。Yan Lecun是深度學習的三巨頭之一,他也是Meta(原Facebook)公司的首席AI科學家。他認為機器和人類不一樣,人類會在心智里面構建一個虛擬世界,進行推理和模擬,這點目前機器做不到。

著名語言學家喬姆斯基在2019年的一次采訪中提到,深度學習更偏工程,有點像推土機,可以使用,但它沒有能力告訴你人類語言的任何事情。(注:ChatGPT這類語言模型可以輸出很精彩的文本,但是我們沒有確鑿證據證明它真正掌握了語言的規律,當然也有可能是它掌握了規律,但人類無法理解。)

Kyle Mahowald等學者認為,“擅長語言” 未必 “擅長思考”。雖然人類的語言和思想是不可分離的,但專?處理語言的人腦區域,與負責記憶、推理和社交技能的人腦區域是分開的。因此不應該對語言模型有過多期望。

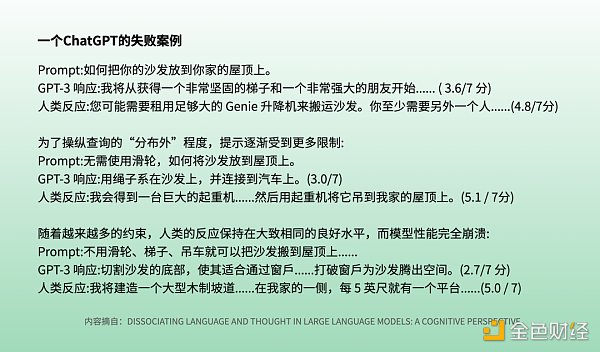

Kyle Mahowald提到了一個GPT-3沒能理解的失敗案例:怎么把沙發放到你家屋頂上。

就像我們在上文提到的,屋頂、沙發、起重機等更偏世界的物理知識,對于人類來說,很容易就想到用各種辦法把沙發放到屋頂上去,但你很難讓ChatGPT理解這樣的操作思路。這個例子也說明世界物理知識的輸入,特別是視覺等多模態數據輸入的重要性。

講完ChatGPT究竟是什么,我們再來講一下背后的技術。

我們在上文提到,ChatGPT相當于用“文字接龍”這樣簡單的技術原理來訓練和使用語言模型,從而實現跟人類的高質量智能文本對話。這個技術原理,理論上是有升級和改善機會的,從而可能達到更好的效果。

在神經網絡參數量方面,業界有人認為有優化空間,例如是否可以用參數量較小的模型達到同等效果。2048個token文本輸入窗口的設計及計算機制,也可能有優化空間。例如當前有人試圖讓ChatGPT寫推理小說,但推理小說里面的推理線索往往不易察覺且距離較遠(例如好幾個章節之前的一個小線索),這個距離遠遠超出2048個token文本的窗口,如何把當前窗口之外的知識信息容納進來,也存在優化可能。

整體而言,作為底層算法模型的Transformer在2017年6月才誕生,現在還處在發展早期,在快速迭代和改進完善之中,應該還有很多發展空間。

此外,前面提到的多模態數據輸入,會給GPT-4帶來什么樣的能力涌現和性能提升,也是業內人士和群眾翹首以待的。

▍人類可以從ChatGPT中學到什么關于語言的規律?

在對人類語言的探索上,ChatGPT比以往的任何產品都走得更遠更深。我們人類可以從ChatGPT身上學到什么?

Stephen wolfram這名科學家認為,人類語言可能沒那么復雜,只是因為我們人類沒有能力理解和掌握其背后的規律;而ChatGPT用基于神經網絡的算法,成功解碼了人類語言的本質。

據OpenAI公開的GPT-2的論文,GPT-2的訓練數據是純英語文本(做了非英語文本過濾)。即便如此,它還是顯示出一些多語言能力,并且展現出非常出色的法英互譯能力,盡管只是接受了10MB左右殘留的法語文本訓練數據。

這個現象引發了人們的思考,當前人類在語言學習方面花費大量的時間和精力,這個學習效率是不是有提升的空間?我們能不能向語言模型學習,更加有效率地學習人類語言?

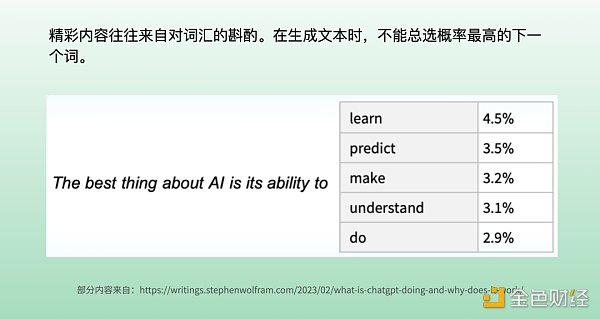

ChatGPT在生成文本時,是每次選擇一個詞,這個詞是在語言模型給出的概率表中做出的選擇。當前科研人員的發現是,如果每次都選擇概率最高的詞匯,理論上是最優解,最后呈現卻往往是一篇非常普通的文章;如果不是每次選擇最優解,例如隨機選擇排名稍微靠后一點的,卻有更大機會生成一篇精彩文章。這也是個有意思的未解之謎。

VeChain相關虛假直播吸引3.8萬名觀眾,目前僅騙得5800美元:金色財經報道,VeChain正成為YouTube上虛假直播的最新目標。該直播承諾將贈送十億枚VET代幣,目前已有3.8萬名觀眾。到目前為止,實際上只有3個人轉賬,僅轉入了320,000枚VET,這使得詐騙者目前的收入為5800美元。[2020/7/18]

以前,我們可能認為創作一篇散文或者一首詩,背后是人類精心的構思和創造。但對于AI而言,創作意味著概率和選擇,我們認為的精彩文章創作原來只是AI枯燥的選擇過程而已。由ChatGPT反觀,可能人類對語言本身的奧秘還知之甚少。

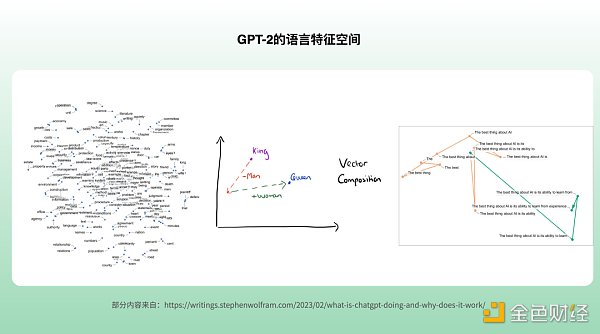

▍語言特征空間的單詞分布

GPT把文字向量化了,建立了語言的高維特征空間,也稱為隱含空間(Latent Space)。

GPT-2中每個詞是一個768維的向量,GPT-3中每個詞則是12288維的向量。每一個維度代表著一個屬性,相當于GPT-3用1萬多種屬性,來描述人類語言中的詞匯特征。

Stephen wolfram試圖打開人類語言的特征空間,來觀察其中的規律。他選擇規模較小的GPT-2的特征空間,把它映射到人類比較容易理解的二維空間,從中發現了許多有意思的現象。比如,crocodile鱷魚 和 alligator短吻鱷 離得很近,蘋果跟梨聚在一起,這個可能容易理解。有趣的是,詞匯之間的關系,還能從向量加減操作中反映出來,比如皇帝(King)的向量減去男人(man)的向量,再加上女人(woman)的向量,就變成了女皇(Queen)的向量。

另外,他還試圖在GPT-2的語言特征空間中,尋找每次生成一個句子的游走規律,我們能從上面這個圖片中,看到GPT-2是怎么在768維度的空間中游走并陸續做出下一個詞的選擇,但是很遺憾他還沒有找到其中的規律。雖然從高維映射到二維中丟失了很多信息,但是未來如果能結合多維空間中的向量,我們可能會發現更多關于語言的規律。

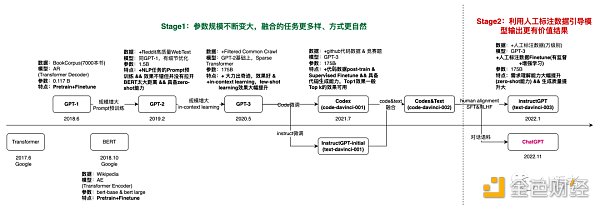

▍Transformer神經網絡算法架構及注意力機制

2017年6月,Google發表了非常著名的Transformer論文,論文標題是《Attention is all you need》,意思是說你只需要注意力機制就足夠了。

圖片來源: 知乎@雅正沖蛋

Transformer神經網絡算法架構的框圖如上,如前文所述,左邊部分是編碼器,右邊部分是解碼器。Google研發的BERT用的是編碼器,而OpenAI的GPT系列用的是解碼器。

在AI領域,有四大類神經網絡算法,包括MLP、CNN、RNN、Transformer。MLP是多層感知器,CNN是卷積神經網絡,RNN是循環神經網絡。

Transformer是最新的算法模型。在一些場景中,它正在逐漸替代CNN和RNN。Transformer的特征提取能力比較強,擅長長序列處理、并行計算、多模態處理等。Transformer的注意力機制有點像人一樣,選擇性關注,因為資源有限,只會關注最重要的事情。

Transformer已經被廣泛應用在自然語言處理、計算機視覺以及生物科技等領域。生物科技行業用來預測蛋白質三維形狀的Alpha Folder算法就是基于Transformer算法模型來做的。

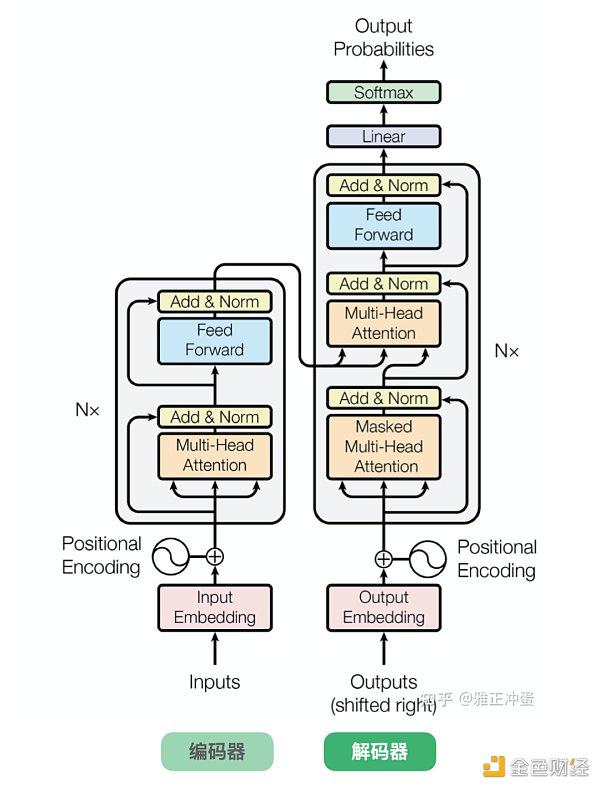

▍哪個模塊是GPT-3儲存智能的地方?

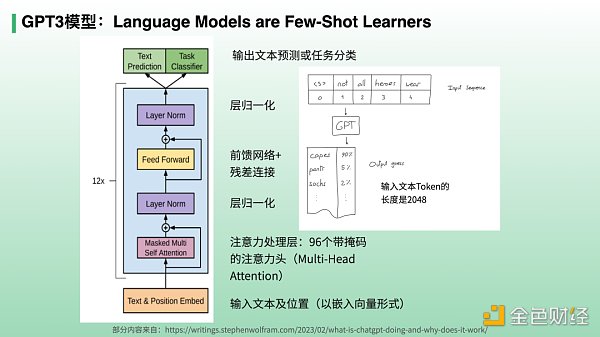

GPT-3模型發布時,OpenAI團隊發布了論文《Language Models are Few-Shot Learners (語言模型是少樣本學習者)》。

上圖是GPT-3模型的框圖,它基本上跟Transformer 的右邊部分的解碼器是類似的。無論是預訓練還是推理(做任務),都是從框圖的最底部輸入前面部分的文本(GPT-3模型最大的長度是2048個token),然后經過12次運算,從Text prediction輸出下一個詞概率預測(Task Classifier是微調訓練分支,在此不詳述)。

OKChain月報:OKChain測試網已升級至0.10版本:據6月10日OKChain官方發布的月報顯示,在OKChain公鏈技術方面,其測試網已升級至0.10版本,新增超級節點競選及一票多投等功能。并通過OpenDEX向用戶提供了運營DEX的核心技術,可以開設DEX和發行交易對。

據悉,OKChain現已全面開啟超級節點候選人招募,在測試網階段成為超級節點的機構和項目,將在主網第一階段保留超級節點名額。

在產品設計方面,OpenDEX桌面版設計已完成50%,原型稿進入UI設計階段;DEXOperator功能已實現45%;幣幣杠桿開發進度完成60%。此外,Wasm智能合約及同構跨鏈等產品功能也實現突破性進展,其中測試合約代碼已完成60%,跨鏈測試已完成并正式接入Iris錢包。

在生態建設方面,目前已有三十余家來自公鏈、瀏覽器、錢包、礦池以及安全機構等五大領域的機構和項目方加入到OKChain生態建設。版本升級后收到包括FIBOS、Kava、Bytom、CertiK、IRISnet、NULS、Vite、YeeCo以及TruChain等多個機構的提案支持。

此外,OKChain首屆“黑客松”大賽已正式啟動,開發者可通過對OKChain技術發展、產品設計以及生態規劃進行提案,也可以基于OKChain測試網打造開發者工具、制作瀏覽器和錢包以及提供staking產品服務等。優秀參賽團隊最高可獲得價值5000美金的OKB獎勵。[2020/6/10]

一個有意思的話題是,GPT-3用1750億個參數,去學習接近5000億單詞的文本,顯然它不是簡單地把3個單詞存在1個參數中去,而是大抵掌握了一些語言規律且抽象了某些知識和能力。那么,問題來了,這些規律、知識和能力到底存在哪些地方呢?

有學者認為,1750億參數主要集中在框圖中的注意力處理層和前饋網絡層,前者的值是動態計算的(每輸入2048個token,就重新計算一次),它們是數據相關的動態權重,因為它們會根據數據動態變化。而前饋網絡層的權重是隨著訓練過程而緩慢變化的,因此,有學者猜想在前饋網絡層中存儲著GPT發現的語言規律、知識和能力等,因為要經過12次運算,運算次數越靠后存儲的信息越抽象。

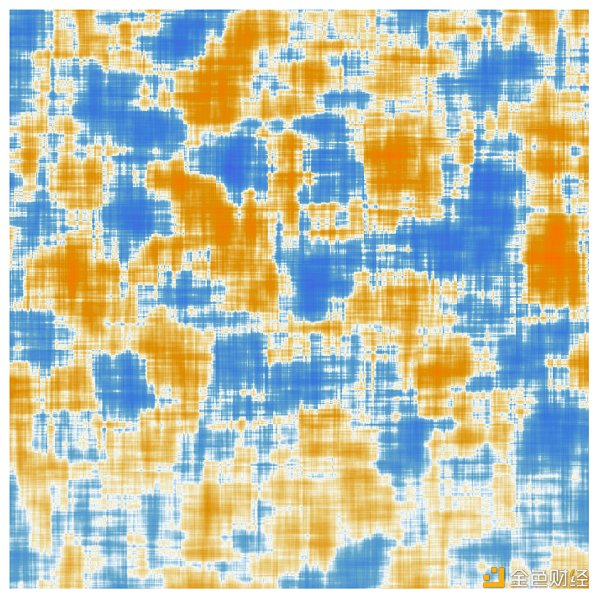

Stephen wolfram把GPT-2的某個前饋網絡層存儲的768*768維度的權重參數矩陣提取出來,壓縮到64x64尺寸,就形成了如下一張神秘的圖像,代表著GPT-2總結的神秘的人類語言編碼規律及其他一些知識和能力的一部分。很好奇什么時候科學家可以逐步解密其中的部分內容,相信對于人類提升自我能力有好處。

圖片來源:writings.stephenwolfram.com

和AI相比,自我意識和自由意志可以算作是人類最后的堡壘。

但是有一種觀點認為,人類其實沒有所謂的自由意志。人類有兩個自我,一種是體驗自我,另一種是陳述自我。體驗自我,負責相對“機械”地解讀信息、作出決策;陳述自我,則負責對體驗自我的決策進行解釋和表述,有時甚至會虛構故事來“欺騙”我們自己。所謂的自由意志,不過是陳述型自我給自己編的一個故事而已。

一些科學家和學者認為,理論上,我們可以構造出一個自我模擬的自指機器(Self-referential Machine),讓它也具備兩套體系,一個負責執行算法,另一個則專門負責對自我進行模擬(描述,或者可稱為在內嵌虛擬世界中模擬自我)。這種機器會表現得就“像”一個具有自我意識的系統,以至于我們可以用這樣的系統來定義所謂的“自我意識”。在古代歐洲,有一種傳說中的銜尾蛇,能夠自己吃自己,實現持續進化。后來,有人提出哥德爾機( G?del Machine)的設想,認為只要程序能夠模擬自身、改造自身,那么我們就可以將其稱為具有自我意識的。此外,還有Quine程序結構、克萊因Kleene第二遞歸定理等也提出和支持了與之相似的假設。

圖片來源:維基百科

我們很難預料,未來機器是否能進化出自我意識。

需要指出,當前討論的生成式AI,跟之前的分析式AI是有較大不同的。分析式AI的主要能力是分析,例如:數據分析、趨勢預測、商品推薦、圖像識別等,而生成式AI主要的能力是創造,例如:寫詩、繪畫、設計產品、編寫代碼等。

當前除語言模型外,生成式AI領域的其他進展還包括圖像生成模型等等。未來,多模態(文本、圖、視頻等)對齊、融合、理解和生成等方向的進展,意義也非常重大。

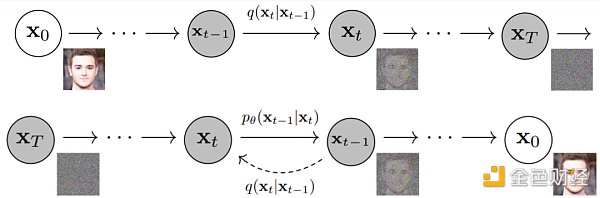

關于圖像生成模型,不得不提的是擴散模型(Diffusion Model)。它主要解決通過文本生成圖像及其他媒體格式的難題,業內知名的擴散模型包括:DALIE2、Stable Diffusion等。

圖片來源:Denoising Diffusion Probabilistic Models

2022年,大語言模型爆發。據統計,2022年,平均每4天就有一個新的大語言模型問世。

生成式AI技術也在持續引發人們對一些知名的模型層平臺和應用的訪問,數據增長很快,投資火熱。2019 年至2021年期間,流向生成式AI業務的資本增加了約130%,其中文本和寫作增長630%、圖像增長400%、數據增長 370% 、音頻/視頻增長350% 。

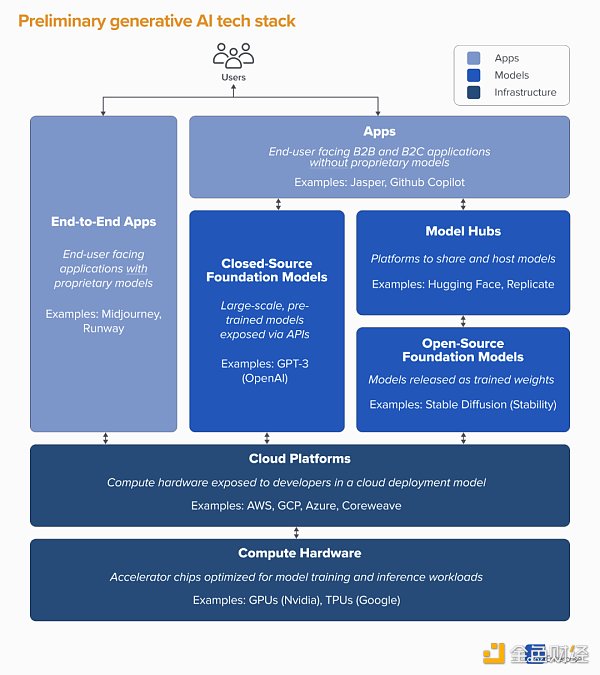

圖片來源:A16Z

上圖是投資公司A16Z總結的生成式AI的行業堆棧。底層深藍色的部分是基礎硬件和云平臺,中間藍色的部分是模型層,再往上淺藍色的部分是應用層。

在應用層,有的創業公司自身只做應用,模型能力則是調用外部的;還有一類叫端到端的應用模式,它會自己做模型,但一般不做大模型,或者在其他大模型基礎上微調出自己的模型。

在模型層,有開源模型和閉源模型。深藍色部分的Model hubs是用于模型存儲和訓練的第三方平臺。

當前應用層的增長比較快,主要是由AI賦能的新型應用案例所驅動,主要集中在圖像生成、文案寫作和代碼編寫,三個類別各自的年收入已超1億美元。

關于生成式AI的創業,我有6點思考和建議:

第一,目前,與AI相關的科研、工程、產品和商業化,都在同時快速迭代,變數很大。這個過程中,會出現不同的技術分支和業務路徑,如果選錯了技術分支和業務路徑,再掉頭就很麻煩。這就需要創業團隊既懂技術又懂業務,在創業初期努力做出正確選擇。

第二,對創業公司而言,從應用層或者端到端的應用層切入,可能是相對能降低風險的做法。模型層有少量機會,但不一定適合大部分的創業者。第三,應用層在做商業模型設計的時候,要警惕模型層的邊界。

以Jasper公司為例。2020年在GPT-3模型基礎上,Jasper衍生出付費商業文本寫作的商業模式。到了2022年底,ChatGPT向用戶免費開放,給Jasper帶來較大的壓力。盡管OpenAI未必會以商業文本生成作為自己的主要商業模式,但它平等賦能了入場的其他競爭者。Jasper需要展現出有競爭力的技術積累與業務縱深,才能穩住腳跟。

第四,把AI技術應用到產業場景,可分為新模式和舊模式改造兩類方式。新模式是指創造之前沒有的全新的應用場景,舊模式改造則指在現有產業場景里用AI技術來改造部分環節,或者團隊帶著深度行業認知和新的AI技術在成熟的產業場景中創業。新模式和舊模式改造,都存在巨大的機會。

在峰瑞已投企業中,有好幾家企業在垂直產業的場景中做業務創新。比如線上心理咨詢平臺閣樓、短視頻及直播SAAS服務企業特看科技、線上健身私教平臺BodyPark,都在積極使用生成式AI來賦能自己的業務。本周六(3月11日),我們將邀請這3家公司的創始人來分享他們的探索和發現,歡迎參與。

第五,AI還面臨科研知識快速溢出的問題,因此找到自己的壁壘很重要。創業公司一定要想清楚自己未來的壁壘在哪里,比如到底是數據壁壘、工程壁壘(例如模型微調)、場景壁壘,還是規模壁壘等等。在應用層創業,僅依靠外部模型層提供的能力,是無法形成壁壘的。

第六,應用層的創業,應該是“技術為先、場景為重”。

“技術為先”,是指雖然通用AI技術未必是你的核心壁壘,但團隊一定要懂技術,才有能力思考如何更早更好地把技術應用到合適的應用場景里,做出好用的產品。

“場景為重”,意味著最后的產品和業務需要找到合適的落地場景,建立自己的商業模式,并在場景里形成自己的核心競爭力。

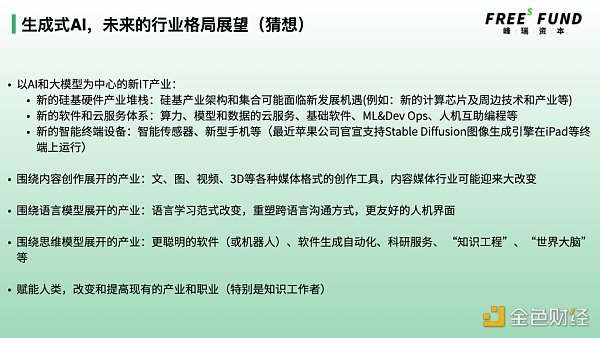

最后來聊聊對AI行業格局的未來展望和猜想。這個部分我參考了奇績創壇陸奇博士之前的一個思考框架。

▍以AI和大模型為中心的新IT

新的硅基硬件產業:硅基產業架構和集合可能迎來新的發展機遇(例如:新的計算芯片及周邊技術和產業等)。

新的軟件和云服務體系:算力、模型和數據的云服務、基礎軟件、ML&Dev Ops、人機互助編程工具等。

▍新的基礎智能終端設備:智能傳感器、新型手機等

未來的智能終端會越來越智能,最近蘋果公司官宣支持Stable Diffusion圖像生成模型在iPad等終端上運行,也有工程師把經過裁剪的Stable Diffusion應用在iPhone上運行起來,可以預見以后我們的手機美顏和照片生成可以達到何等出神入化的境界。

此外,當前的翻譯軟件技術,在語義理解方面還是比較淺,翻譯質量差強人意。如果可以把類似ChatGPT這樣的語言模型能力嵌入到智能終端中去,隨著文本和語音的實時翻譯成為可能,跨語言交流將變得很方便,這對于提升人類之間的交流效率意義重大。

▍圍繞內容創作展開的產業

文、圖、視頻、3D等各種媒體格式的AI內容創作工具,是當前可以看到創業機會較多的新產業。

以ChatGPT為代表的語言模型的文本生成技術,和以擴散模型為代表的圖像視頻多模態生成技術,可能會對內容產業產生深遠的影響。從PGC到UGC,再到如今的AIGC,內容領域會有更多新變化與新玩法。

從媒體行業發展情況來看,當前頭部的內容媒體平臺比如抖音快手B站是所謂的Web2.0平臺,普遍采用UGC方式為主來生產內容,但是隨著AI生產內容(AIGC)的出現,AI可以生成大量優秀內容,成本較低、效果精良,而且甚至不乏創意,這個情況下內容媒體平臺和行業就有可能出現較大的變化。

▍圍繞語言模型展開的產業

在這個領域,新的機會可能包括:語言學習范式改變,重塑跨語言溝通方式,更友好的人機界面等。

其中特別值得一提的,是語言學習范式的改變。如前文所述,如果我們可以打開語言模型,從中尋找到語言學習的規律,說不定可以幫助我們更有效率地學習語言。事實上,OpenAI投資了一家韓國的英語學習APP叫Speak。從有限的公開信息來看,這家公司未來的產品是一個語言學習助手,或者叫做虛擬語言老師——借助語言模型的能力和發現的語言規律,去幫助人們更好地學習外語,而且成本極低。

跨語言溝通的技術目前還不成熟。如前面所說,如果我們能夠把語言模型加載到智能終端,可能會極大改進跨語言溝通的能力。

因為語言模型足夠強大,未來我們的人機界面,會采用更友好的自然語言人機界面,無論是跟APP對話還是跟智能硬件對話。

▍圍繞思維模型展開的產業

不妨暢想一下,更聰明的軟件(或機器人)、科研服務、 “知識工程”、“世界大腦”等。

當前的軟件產業,即便有AI的加持,通用性和智能程度還是不盡如人意的,大多數情況下只能做一些特定的任務,只能成為人類的效率助手;隨著更加通用的AI能力出現,軟件也可以像人類一樣思考和做事,可以想象軟件就可以幫助人類承接較為完整的任務了。

如果AI可以發展出接近人類的思維能力,它也許可以成為人類科學家的科研助手,因為AI可以不知疲倦,且可廣泛使用。當前,我們很難想象AI可以達到人類頂尖科學家的水平。打個比方,你讓它去證明下哥德巴赫猜想,應該還是很不現實的。當然也有其他可能,如前文所述,如果AI程序可以實現自我優化,具備迭代自己的算法和技術的能力,相信它的智能會很快趕上來。

如果我們展開想象,就可以有更多的可能性。例如“知識工程”,如果把人類的知識建模,然后讓人類以某種方式可以調用或者學習,那么就不用經過“痛苦”的學習過程。“世界大腦”,是指規模極大的思維模型,它可以幫助我們執行各種重要的計算和思考。不過,如果真的發展到這個地步,可能離電影《黑客帝國》里邊的Matrix就不遠了。

▍賦能人類,深入改變各行各業(特別是知識工作者)

語言是人類最主要的溝通方式,是知識和思維的主要載體;而深度思維是人類的高階能力,也是人類不同于其他物種的最重要的能力。如果AI掌握了這兩種能力,就基本具備了在某種程度上賦能或替代一部分人類知識工作者的可能。

類似于自動化生產制造設備賦能傳統工業,各類AI模型和應用軟件也將有機會更好地賦能各行各業。但是不同于制造行業,大批量使用的軟件,其邊際使用成本是非常低的,而且它很聰明、善學習、會思考、會交流,應該會有大量的應用場景有待開發。這里邊有非常多的創業機會,也會給各行各業帶來新的發展動力。

首先,ChatGPT是語言模型領域的重大進展,鑒于語言對人類溝通和思維的重大意義,語言模型本身具備很強的通用性,以及人類可以通過研究語言模型獲取語言及知識的學習規律并得到效率提升,這些都會持續帶來長期的創新機會。

第二,AI在思維機器這個方向上還有更遠的路可以走。例如,如果AI能夠實現良好的多模態信息輸入,增加對物理世界的理解,可能可以“涌現”出更多的智能。這個方向的任何進步都意義重大。

第三,與AIGC相關的底層技術原理和算法都還處在發展早期,未來還有很長的迭代和優化機會。

一切,才剛剛開始。

AI之勢

個人專欄

閱讀更多

金色財經 善歐巴

金色早8點

Arcane Labs

MarsBit

Odaily星球日報

歐科云鏈

深潮TechFlow

BTCStudy

澎湃新聞

有人說,美元即將走向終結。因為美聯儲向銀行系統提供緊急流動性,這意味著重啟量化寬松政策。這一次,美國將無限印鈔,美元將比舊金山的風投機構在硅谷銀行失敗時向美聯儲發送推文的速度更快地崩潰.

1900/1/1 0:00:00從區塊鏈層面出發,以太坊生命的初始階段是單一的(monolithic)。這意味著在最初的幾年里,Layer 1以太坊主網全權負責執行自己的交易,促進自己的網絡安全,并為自己的數據可用性提供服務.

1900/1/1 0:00:003 月 23 日,黑山內政部長 Filip Adzic 在其社交平臺宣布,Terraform Labs 創始人 Do Kwon 在黑山被捕.

1900/1/1 0:00:00作者:閃電HSL 來源:作者同名公號我在視頻號里小米的電視業務高管講他和雷軍開會的一個故事。高管在會上說,這個季度我們電視業務利潤多少。。。

1900/1/1 0:00:00原文作者:Rapolas 編譯:LlamaC 「推薦寄語:在進入行業的第一天起,任何人都絕對無法預測到有天自己可能成為一名鏈上的醫藥資本家,而這一切正在悄然發生.

1900/1/1 0:00:00一個多月前,想要探索比特幣 NFT 世界,需要下載安裝 Bitcoin Core,花費可能數日的時間等待同步比特幣誕生至今的所有區塊數據.

1900/1/1 0:00:00