BTC/HKD+0.98%

BTC/HKD+0.98% ETH/HKD+0.99%

ETH/HKD+0.99% LTC/HKD+0.26%

LTC/HKD+0.26% ADA/HKD+1.8%

ADA/HKD+1.8% SOL/HKD+4.88%

SOL/HKD+4.88% XRP/HKD+1.23%

XRP/HKD+1.23%

作者|劉大一恒、齊煒禎、晏宇、宮葉云、段楠、周明

編者按:微軟亞洲研究院提出新的預訓練模型ProphetNet,提出了一種新的自監督學習目標——同時預測多個未來字符,在序列到序列的多個自然語言生成任務都取得了優異性能。

大規模預訓練語言模型在自然語言理解和自然語言生成中都取得了突破性成果。這些模型通常使用特殊的自監督學習目標先在大規模無標記語料中進行預訓練,然后在下游任務上微調。

傳統自回歸語言模型通過估計文本語料概率分布被廣泛用于文本建模,序列到序列的建模,以及預訓練語言模型中。這類模型通常使用teacher-forcing的方法訓練,即每一時刻通過給定之前時刻的所有字符以預測下一個時刻的字符。然而,這種方式可能會讓模型偏向于依賴最近的字符,而非通過捕捉長依賴的信息去預測下一個字符。有如以下原因:局部的關系,如兩元字符的組合,往往比長依賴更強烈;Teacher-forcing每一時刻只考慮對下一個字符的預測,并未顯式地讓模型學習對其他未來字符的建模和規劃。最終可能導致模型對局部字符組合的學習過擬合,而對全局的一致性和長依賴欠擬合。尤其是當模型通過貪心解碼的方式生成序列時,序列往往傾向于維持局部的一致性而忽略有意義的全局結構。

Ripple代表律師Lisa R. Zornberg向法院申請退出訴訟案:金色財經報道,根據最近的一份文件,代表Ripple Labs與美國證券交易委員會 (SEC) 打官司的著名美國律師Lisa R. Zornberg在被任命為紐約州首席法律顧問后,正在向法院申請退出訴訟案。Ripple請求法院批準Zornberg的請求,因為她將從2023年7月31日起不再與美國律師事務所Debevoise & Plimpton LLP有任何關系。Ripple指出,Debevoise & Plimpton LLP律所Andrew J. Ceresney、Erol N. Gulay 和 Christopher S. Ford等其他律師將繼續擔任法律代理,Zornberg的退出既不會影響他們,也不會影響公司利益。

如果該動議獲得批準,Zornberg將成為第四位在該案件接近尾聲時退出的律師。[2023/7/29 16:05:13]

ProphetNet

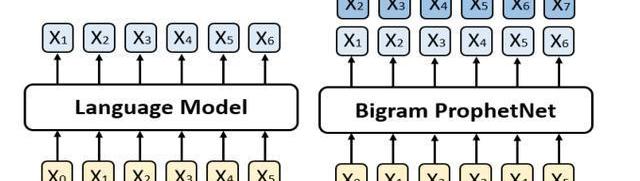

針對上述問題,我們提出了一個新的seq2seq預訓練模型,我們稱之為ProphetNet。該模型帶有一個新穎的自監督學習目標函數,即預測未來的N元組。與傳統seq2seq的Teacher-forcing每一時刻只預測下一個字符不同,ProphetNet每一時刻將學習去同時預測未來的N個字符。如圖1所示:

LaunchZone的早期合約Bscex SwapX存在漏洞導致近780萬美元資金被盜,超3.4萬個地址面臨風險:3月27日消息,據Scam Sniffer監測,LaunchZone的早期合約Bscex SwapX存在漏洞,目前已有7799856美元的資金被盜。在早期批準該合約的用戶面臨風險。34065個地址處于危險之中,請用戶盡快檢查并撤銷授權。

慢霧創始人余弦對此評論稱,誰能想到2~3年前錢包地址授權的一個項目出漏洞,許多用戶一直沒取消授權,有黑客就不斷監測這些存在授權風險敞口的錢包地址,一旦發現有資金就盜走。[2023/3/27 13:28:47]

圖1:左邊是傳統的語言模型,每一時刻預測下一時刻的字符。右邊是Bigram形式下的ProphetNet,每一時刻同時預測未來的兩個字符。

預測未來N元組這一自監督學習目標在訓練過程中顯式地鼓勵模型在預測下一個字符時考慮未來更遠的字符,做到對未來字符的規劃,以防止模型對強局部相關過擬合。

非托管數字資產投資管理平臺ML Tech完成190萬美元戰略融資:12月21日消息,非托管數字資產投資管理平臺ML Tech完成190萬美元戰略融資,Belvedere Strategic Capital、Hyperithm和Nascent參投。ML Tech計劃使用新資金完善其基礎設施并進行客戶獲取、增長和營銷。此前在2021年8月,ML Tech完成175萬美元種子輪融資,由West Loop Ventures領投。

據悉,總部位于美國邁阿密的ML Tech成立于2020年5月,主要為機構投資者提供自動加密交易策略,通過其單獨管理的賬戶(SMA)方法為投資者提供完全的所有權和控制權。截至2022年12月,AUM從2022年6月的500萬美元增加到4500萬美元。[2022/12/21 21:57:49]

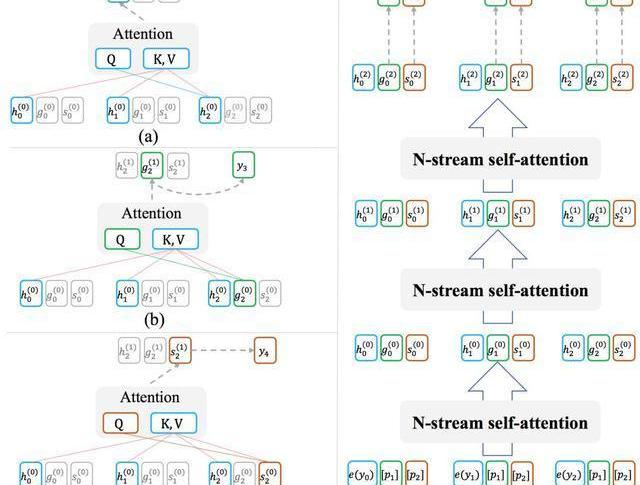

ProphetNet基于Transformer的seq2seq架構,其設計有兩個目標:1.模型能夠以高效的方式在訓練過程中完成每時刻同時預測未來的N個字符;2.模型可以靈活地轉換為傳統的seq2seq架構,以在推理或微調階段兼容現有的方法和任務。為此,我們受XLNet中Two-streamselfattention的啟發,提出了用于模型decoder端的N-streamself-attention機制。圖2展示了bigram形式下的N-streamself-attention樣例。

一匿名巨鯨購入1000億枚SHIB,價值超110萬美元:金色財經報道,據Etherscan監測數據顯示,一個“0xb8e6”開頭的巨鯨地址在KuCoin平臺購買了1000億枚SHIB,價值1,108,000美元,隨后該巨鯨又將購得的SHIB轉移到了一個冷錢包。另據CryptEye數據顯示,至少持有1枚SHIB的地址數量已突破200萬,截至目前為2,197,622個,創歷史新高。[2022/10/10 12:51:58]

除了原始的multi-headself-attention之外,N-streamself-attention包含了額外的N個predictingstreamself-attention,用于分別預測第n個未來時刻的字符所示。每一個predictingstream與mainstream共享參數,我們可以隨時關閉predictingstream以讓模型轉換回傳統seq2seq的模式。

圖2:(a)為mainstreamself-attention;(b)為1-stpredictingstreamself-attention;(c)為2-ndpredictingstreamself-attention;(d)展示了n-streamself-attention的輸入輸出及流程。

Circle允許從固定收益國債產品中 \"免費 \"提前提取USDC:金色財經消息,Circle首席執行官Jeremy Allaire表示,在加密貨幣市場出現多年來最糟糕的表現時,Circle Yield的用戶可以提前取款而不會面臨處罰。自2月推出以來,該貸款部門已完成約2.48億美元的業務。(beincrypto)[2022/7/8 1:59:15]

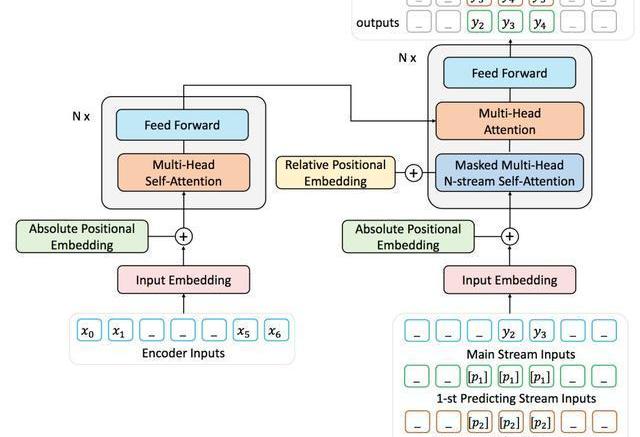

由于難以獲取到大量帶標記的序列對數據,我們用去噪的自編碼任務通過大量無標記文本預訓練ProphetNet。去噪的自編碼任務旨在輸入被噪音函數破壞后的序列,讓模型學習去復原原始序列。該任務被廣泛應于seq2seq模型的預訓練中,如MASS、BART、T5等。本文中使用MASS的預訓練方式,通過引入提出的predictingn-stream自監督學習目標函數預訓練ProphetNet。我們以bigram形式的ProphetNet為例,整個流程如圖3所示:

圖3:二元形式下的Prophet整體框架圖

實驗結果

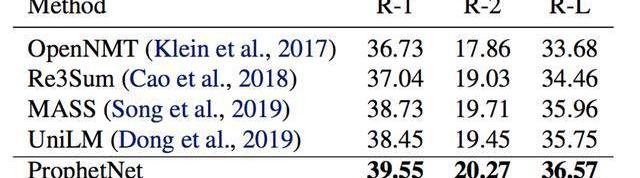

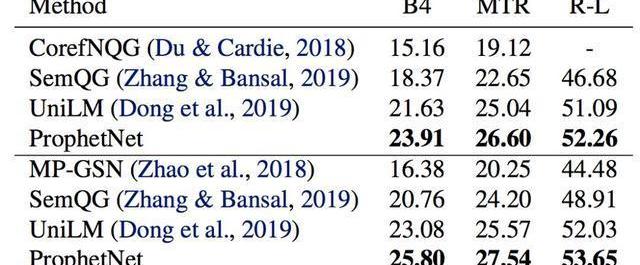

我們使用兩個規模的語料數據訓練ProphetNet。ProphetNet包含12層的encoder和12層的decoder,隱層大小為1024。先在BERT所使用的BookCorpus+Wikipedia的數據上預訓練模型,將模型在Textsummarization和Questiongeneration兩個NLG任務上的三個數據集微調并評估模型性能。與使用同等規模數據的預訓練模型相比,ProphetNet在CNN/DailyMail、Gigaword和SQuAD1.1questiongeneration數據集上都取得了最高的性能,如表1-3所示。

表1:CNN/DailyMail測試集結果

表2:Gigaword測試集結果

表3:SQuAD1.1測試集結果SQuAD1.1交換驗證測試集結果

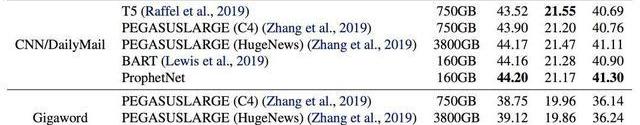

除了使用16GB的語料訓練模型,我們也進行了更大規模的預訓練實驗。該實驗中,我們使用了160GB的語料預訓練ProphetNet。我們展示了預訓練14個epoch后的ProphetNet在CNN/DailyMail和Gigaword兩個任務上微調和測試的結果。如表4所示。需要注意的是,在相同大小的訓練數據下,我們模型的預訓練epoch僅約為BART的三分之一。我們模型的訓練數據使用量僅約為T5和PEGASUSLARGE的五分之一,約為PEGASUSLARGE的二十分之一。盡管如此,我們的模型仍然在CNN/DailyMail上取得了最高的ROUGE-1和ROUGE-LF1scores。并在Gigaword上實現了新的state-of-the-art性能。

表4:模型經大規模語料預訓練后在CNN/DailyMail和Gigaword測試集的結果

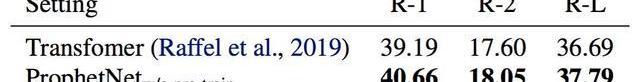

為了進一步探索ProphetNet的性能,我們在不預訓練的情況下比較了ProphetNet和Transformer在CNN/DailyMail上的性能。實驗結果如表5所示,ProphetNet在該任務上超越了同等參數量的Transformer。

表5:模型不經過預訓練在CNN/DailyMail驗證集結果

總結

本文介紹了微軟亞洲研究院在序列到序列模型預訓練的一個工作:ProphetNet,該模型提出了一種新的自監督學習目標,在同一時刻同時預測多個未來字符。并通過提出的N-streamself-attention機制高效地實現了模型在該目標下的訓練。實驗表明,該模型在序列到序列的多個自然語言生成任務都取得了不錯的性能。我們將在之后嘗試使用更大規模的模型架構和語料進行預訓練,并進一步深入地探索該機制。

論文鏈接:https://arxiv.org/pdf/2001.04063.pdf

原力計劃

《原力計劃-學習力挑戰》正式開始!即日起至3月21日,千萬流量支持原創作者!更有專屬等你來挑戰

Python數據清理終極指南口罩檢測識別率驚人,這個Python項目開源了談論新型冠狀病、比特幣、蘋果公司……沃倫巴菲特受訪中的18個金句,值得一看!天貓超市回應大數據殺熟;華為MateXs被熱炒至6萬元;Elasticsearch7.6.1發布一張圖對比阿里、騰訊復工的區別不看就虧系列!這里有完整的Hadoop集群搭建教程,和最易懂的Hadoop概念!|附代碼

一、市場化政策明確汽車電動化趨勢,長期增長空間廣闊1.1歐盟:碳排放政策趨嚴加速行業電動化進程歐盟現行的二氧化碳排放法規為乘用車每行駛1km排放的二氧化碳量不能超過130g.

1900/1/1 0:00:00誕生于法國的勒芒24小時耐力賽(24HoursofLeMans)被全世界所熟知,但起源于美國的“24小時檸檬車耐力賽”(24HoursofLemons)在國內卻很少有人知道.

1900/1/1 0:00:00文/鄢子為編輯/陳曉平 “在風和日麗的時候,假設你駕駛著以風推動的遠洋船,離開港口時,你要先想到萬一懸掛十號風球,你怎么應付。”李嘉誠一直相信,在危機來臨之前,企業應準備抵御風浪的現金.

1900/1/1 0:00:00全球面額最大的紙幣:單張100億的面值滿街都是錢,不少人靠賣錢生活假如,有人現在給你說:"1000000億送你,不用還了。"是不是感覺還挺爽的.

1900/1/1 0:00:00中國青年報客戶端訊福建省首例涉虛擬貨幣的非法獲取計算機信息系統數據案,近日在莆田市告破。據莆田介紹,犯罪嫌疑人許某航,27歲,高中文化,無業.

1900/1/1 0:00:002020年伊始,距離比特幣第三次減半還有不到三個月的時間,經過2017年的非理性癲狂、2018年的一夜回到解放前,2019年的非模式不入場......2020年,整個行業依然陷入迷茫.

1900/1/1 0:00:00