BTC/HKD+0.26%

BTC/HKD+0.26% ETH/HKD-0.33%

ETH/HKD-0.33% LTC/HKD-0.25%

LTC/HKD-0.25% ADA/HKD-1.33%

ADA/HKD-1.33% SOL/HKD-0.22%

SOL/HKD-0.22% XRP/HKD-2.53%

XRP/HKD-2.53%作者:JackyLiang

編譯:DeFi之道Wendy

自OpenAI發布ChatGPT以來,已經過去幾個月的時間了。這個基于大型語言模型的聊天機器人不僅讓許多AI研究員大開眼界,還讓大眾見識到了AI的力量。簡而言之,ChatGPT是一個可以響應人類指令的聊天機器人,可以完成從寫文章、作詩到解釋和調試代碼的任務。該聊天機器人顯示出令人印象深刻的推理能力,其表現明顯優于先前的語言模型。

在這篇文章中,我將從個人角度出發,聊聊ChatGPT對三類人的影響:分別是AI研究員、技術開發人員和普通大眾。在文章中,我將推測ChatGPT等技術的影響,并簡單聊聊我認為可能發生的一些情況。這篇文章更傾向于發表個人觀點,而不是基于事實的報告,所以對這些觀點要持謹慎態度。那么,讓我們開始吧……

ChatGPT之于AI研究員

對我這個AI研究員來說,從ChatGPT上學到的最重要的一課是:管理人類反饋對于提高大型語言模型(LLM)的性能非常重要。ChatGPT改變了我,我猜也改變了許多研究人員對大型語言模型AI對齊問題的看法,我具體解釋一下。

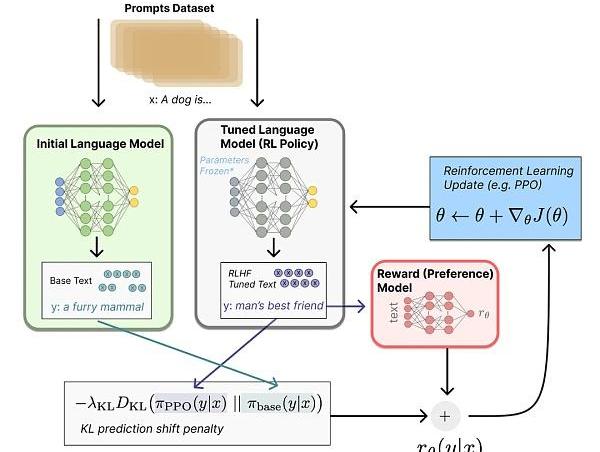

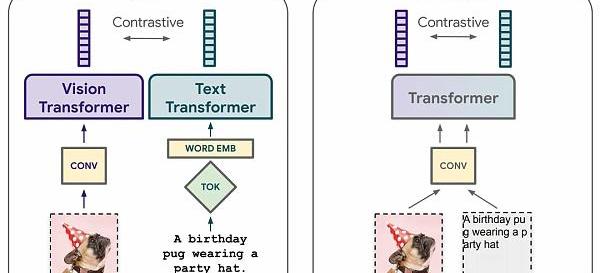

圖:LLM的強化學習與人的反饋

在ChatGPT問世之前,我想當然地認為,當涉及到LLM時,我們面臨著兩個不同的問題。1)提高LLM在某些基于語言的任務中的表現,同時2)避免有害的/破壞性的/有偏見的文本生成。我認為這兩個目標是相關但獨立的,并將第二個問題稱為對齊問題。我從ChatGPT中了解到,對齊和任務表現其實是同一個問題,將LLM的輸出與人類的意圖對齊,既能減少有害內容,也能提高任務表現。

為了更方便理解,這里給出一些背景信息:我們可以將現代的LLM訓練分為兩個步驟。

第一步:神經網絡模型的自監督學習,在給定前一批單詞序列的情況下預測下一個單詞——這是在一個非常大的、互聯網規模的數據集上訓練的。

第二步:通過各種技術使LLM的生成與人類的偏好保持一致,比如在高質量的指令遵循文本的小數據集上微調LLM,并使用強化學習來微調LLM與預測人類偏好的學習獎勵模型。

MakerDAO決定停止向Harbor Trade管理的信貸池提供額外貸款:金色財經報道,在周四中午12點(東部時間)結束的治理投票中,MakerDAO社區選民一致贊成停止向Harbor Trade管理的陷入困境的信貸池提供額外貸款。MakerDAO治理帖子稱,雖然Harbour Trade口頭承諾停止額外提款并自愿關閉金庫,但社區成員對現有700萬債務上限以及該金庫風險敞口可能增加的風險表示擔憂。

Maker價值45億美元的穩定幣DAI由加密貨幣超額抵押的債務頭寸以及越來越多的貸款和債券的代幣化版本支持,以賺取收益。Harbour Trade信用池從MakerDAO鑄造了約150萬美元的DAI穩定幣,并通過向一家消費電子公司提供貸款作為擔保。借款公司未能償還4月份到期的210萬美元債務。[2023/7/21 11:08:00]

在ChatGPT身上,OpenAI很可能使用了許多不同的技術,相互配合來產生最終的模型。另外,OpenAI似乎能夠快速回應網上關于模型出錯的投訴,有時甚至在幾天內就能完成,所以他們也一定有辦法修改/過濾模型的生成,而無需重新訓練/微調模型。

ChatGPT標志著強化學習的悄然回歸。簡而言之,有人類反饋的強化學習首先訓練一個獎勵模型,預測人類會給某一LLM生成內容打多高的分數,然后使用這個獎勵模型通過RL來改善LLM。

我不會在這里過多地討論RL,但OpenAI歷來以其RL能力而聞名,他們寫的OpenAIgym啟動了RL研究,訓練RL代理玩DoTA,并以在數百萬年的模擬數據上使用RL訓練機器人玩魔方而聞名。在OpenAI解散其機器人團隊之后,RL似乎逐漸被OpenAI所遺忘,因為它在生成模型方面的成就主要來自于自我監督學習。ChatGPT的成功依賴于RLHF,它使人們重新關注RL作為改進LLM的實用方法。

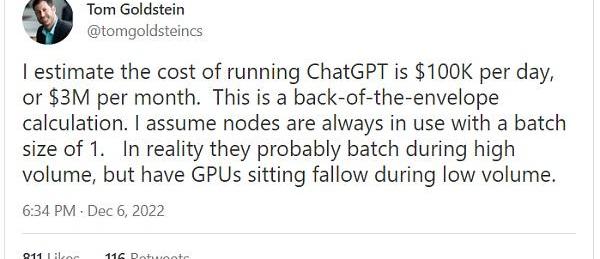

圖:AI專家預測ChatGPT的運行成本

ChatGPT的到來還證明了一點:學術界開發大規模AI功能將越來越困難。雖然這個問題在整個深度學習時代都可能出現,但ChatGPT使它變得更加根深蒂固。不僅訓練基本的GPT-3模型對小型實驗室來說遙不可及,而且ChatGPT的數據收集和RL微調管道可能對學術實驗室造成過大的系統/工程負擔。

數據:周五BTC的波動導致超過68,000名交易者破產:金色財經報道,根據CoinGlass的數據,周五BTC的波動導致超過68,000名交易者破產,清算了1.16億美元的多頭(押注價格上漲)和1億美元的空頭(押注價格下跌)頭寸。當交易所因交易者沒有足夠的資金來維持頭寸而部分或全部損失初始保證金而關閉杠桿頭寸時,就會發生清算。[2023/7/1 22:11:17]

將ChatGPT免費提供給公眾,可以讓OpenAI收集更多寶貴的訓練數據,這些數據對其未來的LLM改進至關重要。這樣一來,公開托管ChatGPT實質上是OpenAI的大規模數據收集工作,而這不是小型組織能夠承擔的。

開源和與HuggingFace和Stability等公司在學術上的大規模合作可能是學術界目前前進的方式,但這些組織總是比擁有更大預算的小團隊前進得慢。我推測,當涉及到最先進的語言模型時,開源通常會滯后于這些公司幾個月到一年。

我認為學術界可能扳回一成的唯一方法是,是否有國家級的計算云專門用于學術AI研究。這無疑將花費數十億美元,需要專門的行政和工程人員。這并非毫無可能——它將類似于詹姆斯?韋伯太空望遠鏡和大型強子對撞機。在美國,一些人已經在呼吁建立國家AI云,進行LLM推理,但訓練和微調LLM和其他基礎模型的能力也同樣重要。鑒于AI國家戰略重要性,我們可能會在不久的將來真正看到這個方向的發展。

同時,AI研究員并不總是要訓練大模型才能產生大影響。我的看法是,與其爭奪下一個最大最好的LLM,較小的學術實驗室可以專注于改善現有LLM的使用,分析它們的優勢和劣勢,并利用有些公司以非常低的成本托管這些非常強大的LLM的事實。例如,可以利用OpenAI和其他公司的現有LLMAPI來進行LLM對齊的研究,而不需要學術實驗室從頭開始訓練這些模型。對強大的LLM的低成本和公開的訪問使得一整套公開的研究能夠發現LLM的新能力和應用。

ChatGPT之于技術從業者

對于那些在技術領域工作和開發產品的人來說,ChatGPT和類似的代碼編寫模型呈現出顯著的一階和二階效應。對于程序員來說,使用基于AI的代碼補全和ChatGPT風格的問答來學習編碼和理解現有的代碼庫將成為軟件工程工作中不可或缺的一部分。我推測,在未來的一年內,許多大學將開設計算機科學課程,教授在軟件工程等應用中利用AI的最佳實踐。

騰訊云副總裁:正在內部探索應用大模型:金色財經報道,5月15日,在第三屆 Light?技術公益創造營上,騰訊云副總裁、騰訊云智能平臺負責人李學朝透露,騰訊的 AI 技術已經開放應用在所有公益方向,騰訊內部很多 C 端產品和 B 端的產業也在廣泛使用。具體到大模型,騰訊內部正在做,現在也有和客戶一起做應用探索,具體進度后續會統一對外公布。[2023/5/16 15:05:06]

ChatGPT和更強大的AI代碼輔助將迫使軟件工程師對其操作的抽象級別進行根本性的重新制定。大多數軟件工程師不需要推理低級機器代碼,因為我們有非常強大的編譯器,可以將人類可讀的代碼轉換為機器可讀的代碼。軟件工程師可以學習這些編譯器的內部工作原理,以及如何編寫最充分利用這些編譯器特點和優勢的代碼,但他們自己不需要編寫機器代碼,也不需要編寫自己的編譯器。

編碼AI很可能會成為新的“編譯器”,將高級額人類指令轉換為低級代碼,但是在更高的抽象級別上。未來的軟件工程師可能會編寫高級文檔、需求和偽代碼,他們會要求AI編碼員編寫今天人們編寫的中級代碼。通過這種方式,我不認為軟件工程師會被AI取代,而是被推到價值鏈的上游。未來,熟練掌握這項技能的軟件工程師可能需要了解不同編碼AI的優缺點,以及如何針對特定的應用領域最好地構建和修改AI。

以上是一階效應,ChatGPT直接影響到技術從業者,特別是軟件工程師的工作方式。對技術產品所能提供的東西的二階影響可能會更深遠。ChatGPT和類似的LLM通過1)釋放全新的能力和2)降低現有能力的成本,使其突然具有經濟意義,從而使新產品成為可能。

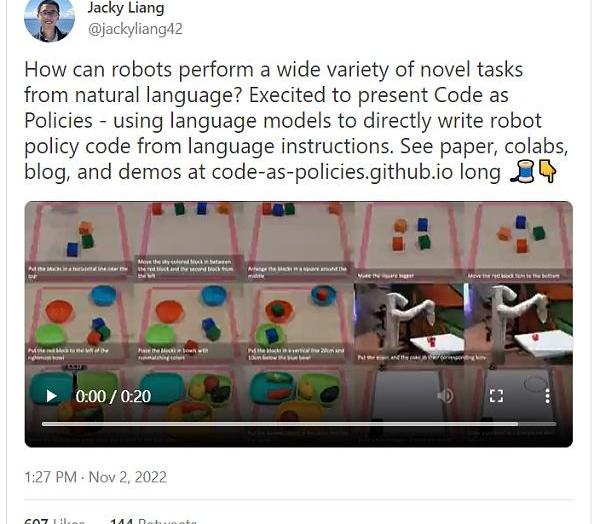

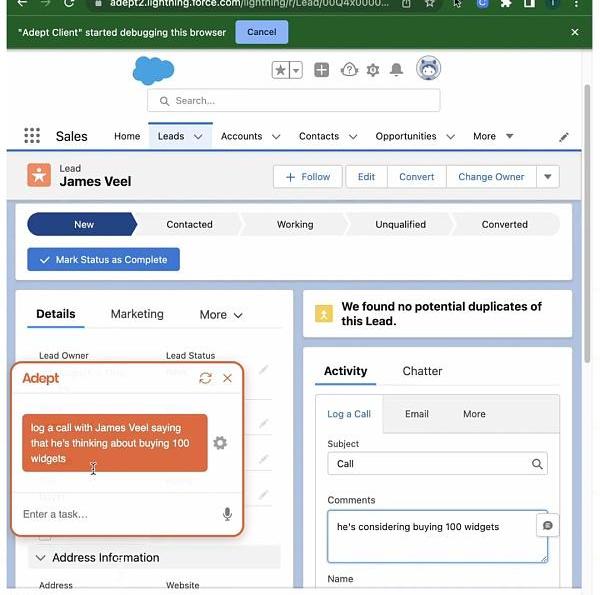

圖:機器人在自然語言中執行新任務

上述第一點的一個例子是,現在我們可以通過簡單地讓AI編碼員將語言指令翻譯成調用該軟件API的代碼,為任何軟件添加自然語言用戶界面。以一種可信賴的和可泛化的方式來做這件事將需要大量的努力,就像發布真正的產品一樣,魔鬼就在細節中。盡管如此,這是一種徹頭徹尾的新能力,我猜測自然語言軟件UI會在所有的軟件平臺上爆發,尤其是在那些傳統用戶界面感到笨重和不方便的平臺上。老實說,很難想象在LLM時代開發一款新應用而不包含一個基于語言的用戶界面會怎么樣。入門的門檻很低,如果你不這樣做,你的競爭對手就會這樣做,而且會提供更好的用戶體驗。

DigiDaigaku將啟動“DRAGON ESSENCE”免費空投:2月12日消息,DigiDaigaku母公司Limit Break首席執行官Gabriel Leydon在社交媒體發文稱,該生態系統NFT持有者(包括Genesis、Heroes和Super Villains)將獲得免費空投的“Dragon Essence”,“Dragon Essence”可以幫助嬰兒龍成長進化,但Gabriel Leydon表示用于空投“Dragon Essence”的快照日期目前待定。

此前,Gabriel Leydon曾透露Limit Break將在北京時間2月13日舉行的第57屆超級碗中投放廣告并開啟新NFT免費鑄造。[2023/2/12 12:02:12]

降低現有能力的成本聽起來不像解鎖新能力那么有吸引力,但它同樣重要。LLM可能存在很多有前景的應用,但為這些下游任務微調LLM的成本可能太高,不值得投資。有了ChatGPT和改進的指令跟蹤,開發者可能不再需要收集大量的數據集來進行微調,而只需要依靠zero-shot性能。預計在許多處理文本輸入的現有應用中,基于文本的分類、摘要和內聯預測功能將出現大量的“小規模”LLM部署。這些對用戶體驗的邊際改善在以前可能投資回報比很低,但現在卻突然值得了。

低成本也意味著在應用LLM和其他基礎模型的業務上有很多唾手可得的成果,通過良好的UI/UX、現有軟件產品內的集成以及有效的進入市場和貨幣化戰略為消費者創造價值。Lensa是一個能滿足所有這些條件的例子。LLM部署的這些更實際的方面往往會超過底層模型的絕對性能,成功的初創公司總是可以將舊的LLM與新的改進版本交換。這也意味著,那些應用LLM的人不應該把他們的技術棧與特定LLM的特性綁得太緊。LLM的快速改進周期,加上可公開訪問的API,以及關鍵的商業差異化因素不是模型本身,這可能意味著LLMs將被商品化。

SBF:破產前杠桿不是約50億美元,而是約130億美元:金色財經報道,FTX創始人SBF在推特發文稱,一個月前FTX是一家有價值的企業。FTX的日交易量約為100億至150億美元,年收入約為10億美元,股權價值高達400億美元。FTX被譽為高效經營公司的典范,是硅谷的寵兒。但過于自信和粗心大意導致問題不斷醞釀。隨后幾天內發生了歷史性崩盤,大多數相關資產暴跌超過50%。與此同時,發生了擠兌,每天大約有25%的客戶資產被取出。杠桿高達130億美元,而不是此前認為的50億美元。高杠桿、資金擠兌、資產價值的全面崩盤突然同時發生。[2022/11/17 13:15:02]

未來將有兩種類型的科技公司能夠繼續向前發展——能夠負擔得起培訓和運行自己的基礎模型的公司,以及負擔不起的公司,后者需要向前者支付基礎模型稅。這聽起來很有戲劇性,但它與我們今天的情況沒有什么不同,技術公司要么托管自己的服務器,要么向AWS/Azure/GCP交稅。AI云業務將是未來云平臺的一個關鍵戰場,并將給競爭對手提供超越現有企業的機會。例如,憑借微軟的經驗和與OpenAI的結合,Azure很有可能憑借其AI云產品超越其他公司。

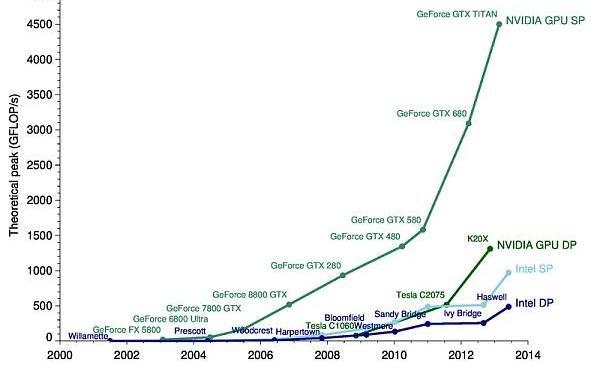

圖:GPU性能的增長速度遠遠快于CPU性能

最后,從一個更具推測性的角度來看,基于深度學習的基礎模型可能會讓我們在相當長一段時間內避免摩爾定律放緩帶來的負面后果。隨著這些模型的能力越來越強,它們將接管越來越多由傳統軟件完成的任務,這意味著越來越多的軟件將可以通過僅僅優化神經網絡的性能而得到優化。神經網絡在GPU和特定應用的芯片上運行,其性能的提高并沒有看到傳統CPU改進的明顯減速,這大致可以在摩爾定律的減速中體現出來。我們真的很幸運,有一個單一的神經網絡架構,即Transformer,它可以代表通用計算,并經過訓練,可以很好地執行這么多不同的任務。我們還沒有接近優化Transformer性能的終點,所以我期望隨著LLM變得更加強大并取代更復雜的傳統軟件堆棧,計算機會變得更快。

ChatGPT之于大眾

視頻?:耶魯大學評ChatGPT,更多是資源,而并非學習的替代品

ChatGPT是許多普通大眾可以直接與之互動的第一項AI技術。當然,在ChatGPT之前,有Siri和Alexa,而且深度學習應用在許多商業應用中已經無處不在了。不同的是,以前部署的AI技術往往都在后臺工作,通過傳統軟件和有限的用戶界面層層"過濾"。公眾通過ChatGPT對AI有了更直接的體驗,用戶可以直接向LLM輸入,并直接看到它的輸出。ChatGPT也明顯比以前的聊天機器人更強大。再加上該服務目前一直是免費的,這些因素將ChatGPT推向了主流世界的討論熱潮。

相對以前,這種和AI的親密接觸讓公眾對AI的新奇和炒作有了更真實的體驗。我可以想象,突然之間,對于那些不熟悉LLM工作原理的人來說,聊天機器人可能具有意識的說法聽起來并不太牽強。這也反映出了一個問題,當涉及到AI的問題時,科學傳播的缺失——我認為AI界在向公眾宣傳和普及AI如何工作、能做什么、不能做什么,以及如何負責任地使用AI技術方面做的非常差。見鬼,我們甚至都不能確定技術從業者了解LLM的基本知識,更不用說普通民眾了,他們才是受這項技術影響的終端用戶。在接下來的幾年里,如果繼續不對AI進行教育和溝通,可能會面臨災難性的后果,因為類似ChatGPT的模型會在沒有適當預防措施的情況下進入關鍵任務的應用。

或者,從某種意義上說,讓人們了解一項新技術的最好方法可能是讓公眾公開地試驗這項技術及其應用,體驗它的失敗,并反復辯論和改進一些流行的觀點。這一波基礎模型的可用性,尤其是ChatGPT開創的免費使用的先例,可以讓公眾通過親身體驗更了解AI,反過來引發更明智的理解和討論。

DALL-E2是第一個真正優秀的文本到圖像生成模型,發布僅僅幾個月后,我們就已經看到了來自公司和社區的一系列不同的政策反應,試圖適應這種新的現實,從完全禁止AI藝術到納入AI藝術圖片的銷售。對于ChatGPT,一些學術會議禁止它的使用,而也有學者則將其列為合著者。圍繞生成式AI也有不少正在進行的訴訟。目前還不清楚使用這些模型的法律和道德方式是什么,但很明顯,這些圍繞AI使用政策的小規模實驗對于公眾弄清楚這些事真的很重要。我個人認為這是一個很好的方向,因為我相信公共政策應該由公眾討論決定,而不是由任何一個托管這些模型的特定科技公司不清不楚的委員會決定。

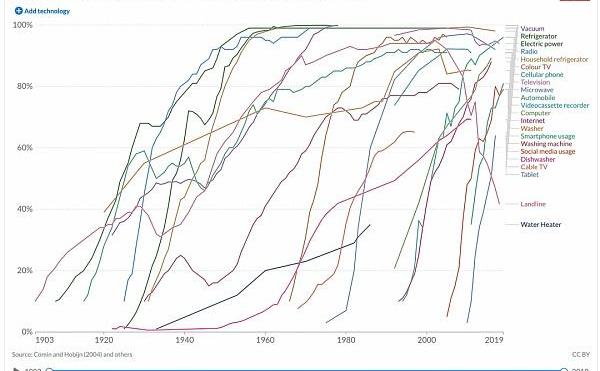

圖:新技術的采用需要時間,盡管隨著時間的推移,采用速度越來越快

關于ChatGPT和類似基礎模型的應用的最后一個想法——技術部署總是比技術創新需要更長的時間,雖然人們可以在一個周末的時間建立令人印象深刻的LLM演示,但仍然需要大量的工作和試錯來建立可靠、可擴展的產品,為消費者帶來價值。在科技領域,我們可能會在2023年看到生成式AI應用的海嘯,但我預計這些應用在公眾中的傳播速度會慢得多。有許多因素會減緩大規模生成式AI的采用——現有系統和產品的慣性,對AI取代人類的認知的文化障礙,運行AI的成本在很多應用中可能沒有意義,LLM輸出的不可靠性和可信度,以及擴大LLM計算基礎設施以實時服務數十億次的查詢。這些挑戰都不會在一夜之間,甚至在幾個月內被克服。但它們最終會被克服,而5年后的世界將看起來非常不同。

未來如何?

如果說在過去10年的深度學習中我們學到了什么,那就是真的很難對AI做出準確的預測,包括它的發展和部署。然而,我可以自信地說,ChatGPT只是未來的一個小預告。對于基礎模型的未來,我在兩個方向上看到了有前景的進展,我認為在今年或明年會有突破性進展:1)真正多模態的ChatGPT級基礎模型,以及2)被設計用于在環境中采取行動的基礎模型。

圖:與其訓練理解視覺和文本的獨立模型,較新的模型可以直接理解圖片中呈現的文本

對于1),想象一個類似ChatGPT的界面,但你不僅可以上傳文本,還可以上傳音頻、圖像、視頻、3D模型以及其他結構化文件,并讓它"理解"、分析、處理和生成這些內容。這樣的技術如今已經存在,將所有這些模式整合到一個模型中似乎很簡單。

對于2),在不久的將來,擁有一個基礎模型,能夠通過鍵盤和鼠標與計算機進行可靠的互動,以執行人類今天的許多日常任務,似乎是合理的。有一些證據表明這是可行的,從瞄準機器人過程自動化的初創公司到試圖訓練AI代理完成Minecraft中的開放式目標的研究人員。為物理機器人而不是虛擬代理開發這種面向動作的基礎模型將更加困難,但進展已經在進行中。

圖:一種語言模型,可以將自然語言指令轉換為與Web端瀏覽器交互的動作

關于商業化,一方面,科技巨頭有能力利用他們龐大的計算資源來訓練真正強大的模型。但另一方面,公共/開源模型也將變得非常流行/易于使用,所以我不確定擁有自己的模型對很多應用來說是一個很大的優勢。如前所述,基礎模型很可能會被商品化。因此,對于已經擁有設備/操作系統的大型科技公司來說,開發適合LLM的平臺,允許其他人使用基礎模型,并在上面建立新的應用,而不是直接與其競爭建立這些應用,這么做才是合理的。

最后,展望未來,我們可能會在未來5年內告別"從互聯網上獲取免費數據"的制度,它真正推動了最近基礎模型的進展。雖然定制數據總是需要用于特定領域的微調/校準,但用大規模的"免費"數據預訓練強大的模型無疑導致了GPT和類似模型的成功。看社區如何超越僅僅搜刮現有的數字數據來提高基礎模型的性能,這將是很有趣的。可以肯定的是,我們仍然會通過更好的訓練和對齊技術來改進模型,但大規模自我監督學習的下一個前沿是什么?下一個10萬億或100萬億的數據點從何而來?我很想知道。

作者:Chloe 以太坊Layer2發展迅猛,Optimism與Arbitrum的處理交易量甚至超過了以太坊主網,而以太坊網絡則自10月以來已下降了約33%.

1900/1/1 0:00:00頭條 ▌比特幣市值超過Visa金色財經報道,數據顯示,比特幣的市值目前為4732.3億美元,在過去24小時內下跌了0.5%。然而,Visa的市值目前為4601.3億美元.

1900/1/1 0:00:00作者:hildobby 談到加密數據,事情并不總是像看起來那樣。在閃亮的大指標背后-通常還有更多的故事。?在本文中,我們將研究NFT市場中的虛假交易現象,以及它如何扭曲關鍵指標.

1900/1/1 0:00:00撰文:Nancy 繼美國監管機構向質押、穩定幣等加密業務揮起監管大棒后,NFT項目也面臨著證券認定的“靈魂拷問”.

1900/1/1 0:00:001月28日,Azuki的Twitter賬號被黑,導致其粉絲連接到釣魚鏈接,超122枚NFT被盜,損失超過78萬美元.

1900/1/1 0:00:00來源:CoinDesk 編譯:Dali@Web3CN.Pro過去幾個月,人工智能受到了廣泛的關注.

1900/1/1 0:00:00